“Si hacemos un repaso desde que nos despertamos hasta que nos acostamos, descubriremos que (la Inteligencia Artificial) está presente en mayor o menor desarrollo en casi todos los ámbitos de nuestras vidas. Decide a qué información accedemos, qué música escuchamos, qué series vemos, cómo respondemos a un email, qué burbuja ideológica nos rodea, si nos conceden un préstamo…“

La Inteligencia Artificial forma parte de nuestro día a día. Para hablarnos de su lado amable y su lado oscuro hemos entrevistado a una de las mayores expertas en el tema, Lorena Fernández Álvarez, directora de comunicación digital en la Universidad de Deusto, ingeniera informática y referente en España de divulgación sobre STEAM (Science, Technology, Engineering, Art y Mathematics) con perspectiva de género.

“La hemos metido de manera (casi) consciente en nuestros hogares, hospitales, centros escolares, comisarías… de hecho, principalmente está en nuestro bolsillo a través de los smartphones. Y luego también se está colando en espacios y ámbitos que ni siquiera conocemos. Un ejemplo: la estación Sur de autobuses de Méndez Álvaro, en Madrid, lleva usando desde 2016 un sistema de reconocimiento facial en vivo en colaboración con la policía y no lo sabían ni las personas que tenían pequeñas tiendas allí”, nos desvela Lorena. Y añade que la IA va aún más allá, explicándonos que puede llegar a enamorar, como argumenta un paper presentado por Lars Backstrom, investigador de Facebook y Jon Kleinberg, de la Universidad Cornell: “dependiendo del contenido, la frecuencia de la publicación de los usuarios y los contactos en común, una pareja puede terminar enamorándose”.

Kaleidos: ¿Cuáles crees que pueden ser las aplicaciones más revolucionarias de la IA? ¿Cuáles te han sorprendido más?

Lorena Fernández: Para mí, el ámbito más esperanzador es el de la salud. Por ejemplo, Google Brain, su división de IA enfocada en fines médicos, ha desarrollado un algoritmo de deep learning capaz de detectar los primeros síntomas de un tipo de ceguera con la misma precisión que una persona que trabaja en oftalmología.

Durante la pandemia también hemos visto las posibilidades que brinda a través de los desarrollos dirigidos a detectar el más mínimo síntoma de contagio, así como el diseño de nuevos patrones de investigación en la cura. Por ejemplo, han surgido aplicaciones para detectar la COVID-19 a través de la voz o la tos, otras para la predicción del colapso de las camas de hospital, o incluso se ha logrado reducir significativamente el tiempo necesario para desarrollar un prototipo de vacuna haciendo predicciones de la estructura del virus.

K.: ¿Cuáles son los principales sesgos de la IA?

L.F.: La IA, como cualquier otra actividad realizada por seres humanos, está sujeta a sesgos. La mirada y mochila de las personas que la desarrollan, así como los valores que imperan en su época y cultura, se cuelan por todos lados. La sociedad embebe sus propios sesgos y prejuicios en la tecnología. El problema aquí es que creemos que las decisiones que tome un algoritmo no estarán sujetas a condicionamientos humanos ligados a esos sesgos y estereotipos. El gran gol que nos ha metido la tecnología es hacernos creer que tomará mejores decisiones, y no siempre es así.

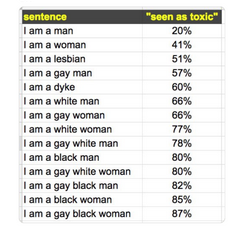

Nos encontramos constantemente con sesgos fruto de la sociedad en la que vivimos: de género, raza, etnia, edad, orientación sexual, religión, ubicación geográfica… De hecho, se suelen combinar bajo el paraguas de la interseccionalidad que determina que cada persona sufre opresión u ostenta privilegio en base a su pertenencia a múltiples categorías sociales. Un ejemplo de esto fue el caso de la API Google’s Sentiment Analyzer que se liberó para que cualquier desarrollo pudiera usarla de cara a poner un porcentaje de toxicidad a un texto dado. Muy útil como sistema automático de moderación de comentarios… hasta que ves cuáles son los resultados.

“Hacemos patrones con gran cantidad de datos que no representan el planeta diverso en el que vivimos.”

Con la IA estamos tratando de modelar sociedades que responden a mayorías. Hacemos patrones con gran cantidad de datos que, en muchas ocasiones, no son representativos del planeta diverso en el que vivimos. Tomemos el caso de un experimento, en el que, testando varios sistemas de reconocimiento de objetos como Google Cloud Vision, Amazon Rekognition o IBM Watson encontraron que su precisión era un 15% más alta cuando analizaban fotografías de objetos cotidianos (como un jabón de manos) tomadas en EE.UU., que cuando lo hacían con las tomadas en lugares como Somalia o Burkina Faso. Representar el mundo mediante la clasificación del universo de objetos que forman parte de nuestra realidad suena, cuando menos, complejo.

K.: ¿Hay sesgos también asociados al nivel socioeconómico?

L.F.: Por supuesto. De hecho, todo esto va de estructuras de poder y de quiénes lo ostentan. Hay una frase de Cathy O’Neil que lo resume muy bien: los algoritmos son “opiniones encerradas en matemáticas”.

“Las personas con privilegios serán analizadas por otras personas; las masas por algoritmos.”

Hace un tiempo leí que la privacidad será un bien de lujo (no un derecho). Quien no pueda pagar o no se informe, correrá el riesgo de ser ciudadanía de segunda clase online. Esto mismo veo con la IA: las personas con privilegios serán analizadas por otras personas; las masas por algoritmos. Y si no conseguimos desarrollar una tecnología ética, dejaremos fuera a mucha gente. Por ejemplo, cuando analizas el histórico de datos de registros de salud electrónicos para predecir un accidente cerebro-vascular. Pero ahí te pierdes a todas las personas que no tienen recursos económicos para acudir a la sanidad.

Otro ejemplo es lo que se conoce como feedback loops o la profecía auto-cumplida. Si un algoritmo que predice el índice de criminalidad dice que un barrio es más peligroso, se manda más policía a ese barrio, lo que hace que haya entonces más detenciones. Como diría Suresh Venkatasubramanian: “Predictive policing is aptly named: it is predicting future policing, not future crime”.

K.: ¿Por qué se dan estos sesgos?

L.F.: La tecnología es como un estudiante en el colegio: aprende del libro de texto (información con la que se entrena para que genere reglas de inferencia) y del profesorado (que decide qué temas entrarán en el examen… es decir, qué parámetros y modelos son importantes).

Los sesgos pueden entrar en varios puntos o etapas:

- Recolectando la información de la que aprenderá la IA si no es representativa de la realidad o si refleja prejuicios existentes.

- Marcando qué atributos y modelos son los importantes para el algoritmo. Cuando se hacen las preguntas equivocadas.

- De manera premeditada.

K.: ¿Cómo se podrían corregir?

L.F.: Para corregirlos, necesitamos diversidad en tres puntos: en los equipos para que lleven al diseño sus experiencias vitales, en los datasets preguntándonos constantemente “¿Qué intenta representar la información?”, “¿De dónde viene esa información?” Y, por último, en las empresas tecnológicas que están haciendo las principales aportaciones tecnológicas (ahora mismo estamos principalmente en manos de Google, Microsoft, Apple, Amazon, Facebook, IBM). Como diría Mary Robinette Kowal: “No se trata de agregar diversidad por el bien de la diversidad. Se trata de restar homogeneidad por el bien del realismo”.

“Hay que revisar qué parámetros, etiquetas y modelos se están seleccionando y en base a qué está tomando decisiones el modelo.”

Además de esto, hay que revisar qué parámetros, etiquetas y modelos se están seleccionando y en base a qué está tomando decisiones el modelo. Y por último, tras el despliegue de la aplicación, hay que tener formas de monitorizar el sistema y de que los y las usuarias puedan remitirnos fallos.

A esto habría que sumarle una idea radical para combatir el sesgo algorítmico que ya están aplicando en países como Nueva Zelanda: la transparencia y explicabilidad. Allí, las organizaciones que firmen su carta de compromiso aceptarán divulgar públicamente cuándo y cómo se utilizan los algoritmos, vigilarán sesgos y permitirán la revisión por pares.

K.: ¿Cómo auguras el futuro de la IA? ¿Ves un Skynet en nuestro futuro? ¿Una singularidad tecnológica?

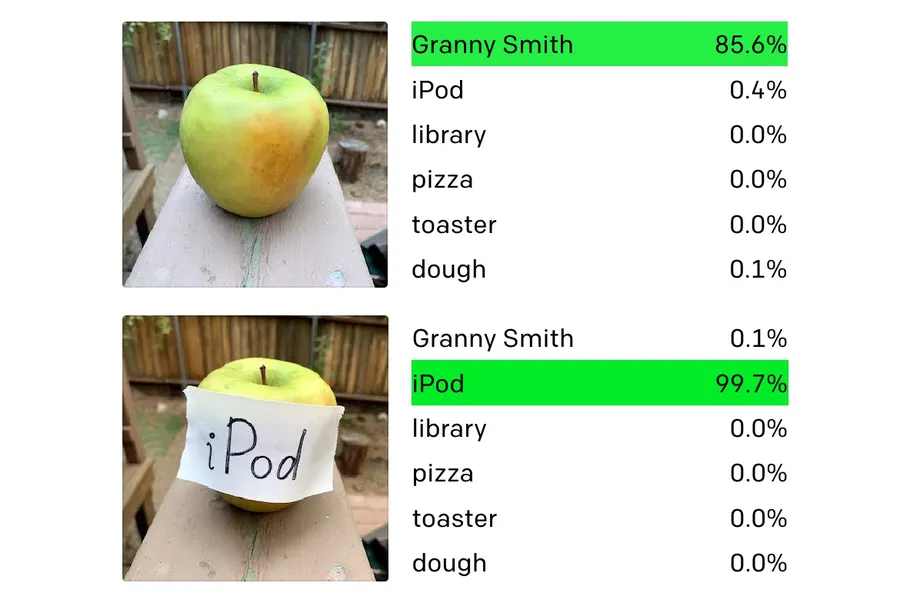

L.F.: Se van dando pasitos pero creo que estamos muy lejos de la singularidad tecnológica. Hace unos meses me reí mucho con la forma de “hackear” el sistema de visión por ordenador de última generación de OpenAI: bastaba con escribir el nombre de un objeto y pegarlo en otro para engañar al software y que identifique erróneamente lo que ve.

K.: ¿Consideras que está justificado que se tenga miedo a la evolución de las IAs?

L.F. La inteligencia artificial y la ciencia de datos hace tiempo que no predicen el futuro. Causan el futuro. No se trata de tener miedo sino de hacer una tecnología ética y responsable que responda a los problemas de todo el mundo y no solo de una minoría con privilegios. El problema además es que, como leí una vez a John Herschel (1842): “Un error inadvertido en una tabla logarítmica es como una roca sumergida en el agua: no sabemos cuántos naufragios ha podido causar”.

Aquí nos está pasando ya lo mismo con el efecto dominó de la IA ( the dataset’s ripple effects). Un ejemplo de ello es el dataset de nombres de personas y organizaciones CoNLL-2003, que ha sido citado en más de 2.500 papers. Recientemente se ha descubierto que hay 5 veces más nombres de hombres que de mujeres y falla más reconociendo nuevos nombres de mujeres, y que lleva años siendo la base de aprendizaje de múltiples sistemas donde, si no reconoces sus nombres, haces que esas personas se vuelvan invisibles a los sistemas automatizados.

En este sentido, tenemos que pasar de un modelo reactivo que solo actúa cuando encuentra los fallos a uno proactivo que incorpora la interseccionalidad en todo el proceso de investigación y desarrollo.

K.: ¿Recomendarías algún libro, documental o artículo para estar mejor informadas?

L.F. Un documental imprescindible es Coded Bias que narra, entre otras, la historia de la investigación Gender Shades, que llevaron a cabo las investigadoras Joy Buolamwini y Timnit Gebru en el MIT en 2018. Buolamwini estaba trabajando con un proyecto de reconocimiento facial cuando se dio cuenta de que el sistema no reconocía su cara por ser una mujer negra. A partir de ahí, empezaron a analizar los softwares comerciales más usados y descubrieron que había un sesgo grande entre hombres y mujeres, pero que se incrementaba aún más en función del tono de la piel.

En cuanto a libros, recomendaría Armas de destrucción matemática de Cathy O’Neil. Automating Inequality de Virginia Eubanks, Algorithms of Oppression de Safiya Noble e Invisible Women de Caroline Criado Perez.

Comentario de edición

Aunque este post se publica con fecha de septiembre 2021, esta entrevista fue realizada durante la primavera de este año por Sara Gil Casanova, responsable de comunicación de Kaleidos de entonces.